RWKV 更新v1.3.5 V1.36最新版本

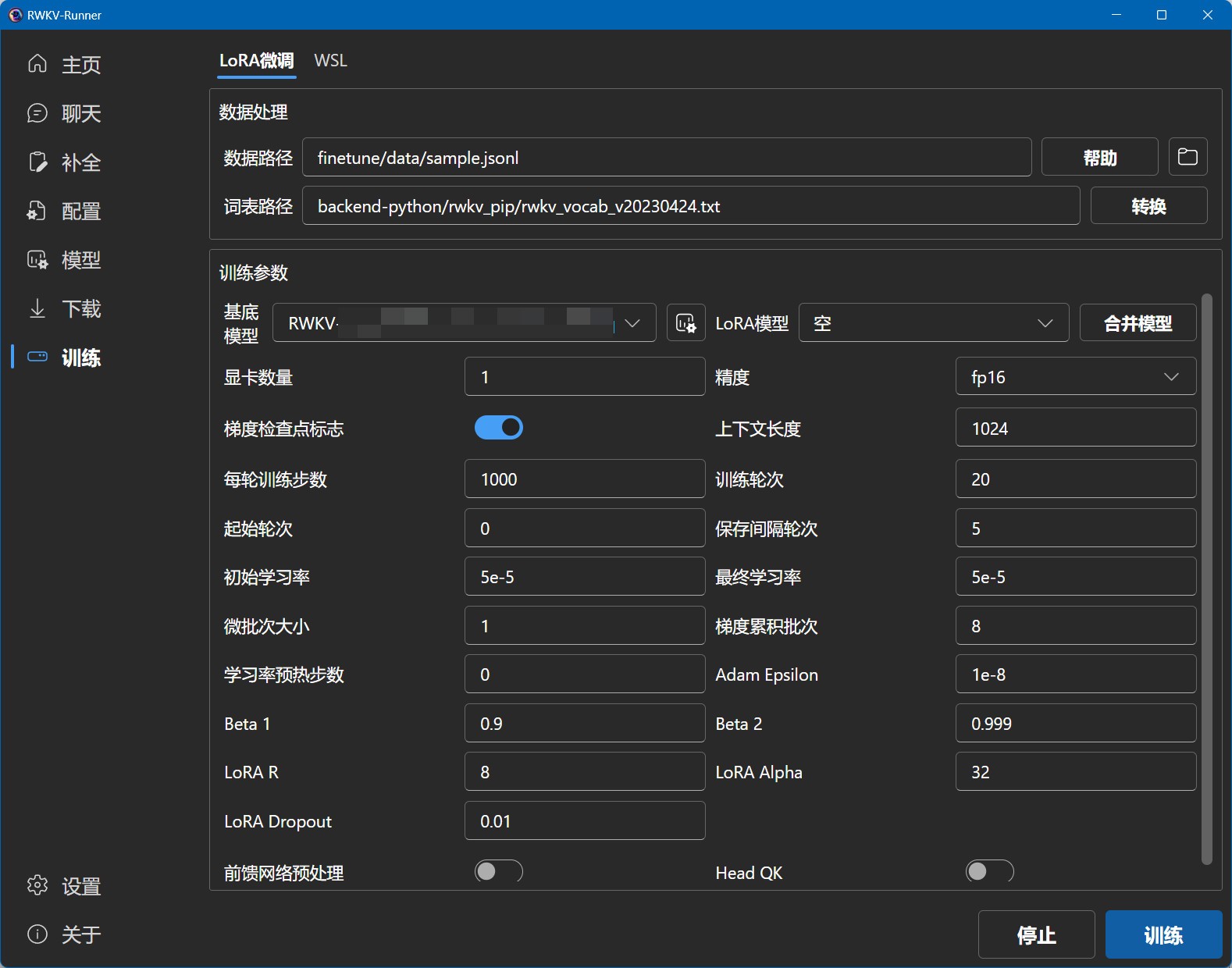

本模型从1.3.5开始 支持本地训练模型!

RWKV模型是什么

RWKV是一个开源且允许商用的大语言模型,灵活性很高且极具发展潜力。

关于本工具

本工具旨在降低大语言模型的使用门槛,做到人人可用,本工具提供了全自动化的依赖和模型管理,你只需要直接点击运行,跟随引导,即可完成本地大语言模型的部署,工具本身体积极小,只需要一个exe即可完成一键部署。

此外,本工具提供了与OpenAI API完全兼容的接口,这意味着你可以把任意ChatGPT客户端用作RWKV的客户端,实现能力拓展,而不局限于聊天。

底部的预设配置规则

本工具内置了一系列预设配置,以降低使用难度,每个配置名的规则,依次代表着:设备-所需显存/内存-模型规模-模型语言。

例如,GPU-8G-3B-CN,表示该配置用于显卡,需要8G显存,模型规模为30亿参数,使用的是中文模型。

模型规模越大,性能要求越高,显存要求也越高,而同样模型规模的配置中,显存占用越高的,运行速度越快。

例如当你有12G显存,但运行GPU-12G-7B-CN配置速度比较慢,可降级成GPU-8G-3B-CN,将会大幅提速。

关于RWKV

RWKV是具有Transformer级别LLM性能的RNN,也可以像GPT Transformer一样直接进行训练(可并行化)。而且它是100% attention-free的。你只需在位置t处获得隐藏状态即可计算位置t + 1处的状态。你可以使用“GPT”模式快速计算用于“RNN”模式的隐藏状态。

因此,它将RNN和Transformer的优点结合起来 - 高性能、快速推理、节省显存、快速训练、“无限”上下文长度以及免费的语句嵌入(使用最终隐藏状态)。

官方网站 github https://github.com/josStorer/RWKV-Runner

初始发布时间 2023 May 21 v1.0.0

V1.36变化

修复使用目录作为训练数据时的 jsonl 数据

修复损失解析器

改进训练错误消息

更新标志

额外的VC检查

修复 load_state_dict 崩溃

v1.3.5变化

修复 Macos 和 Linux 的构建

更新相关存储库

修复损失解析器

改进 wsl 依赖项安装

改进微调指南

实时刷新本地模型(#98)

改进 python 脚本错误消息

支持使用目录作为训练数据

变化

提高微调兼容性

V1.36 Changes

fix jsonl data when using directory as training data

fix loss parser

improve error messages for training

update logo

extra vc check

fix load_state_dict crash

Install

Windows: https://github.com/josStorer/RWKV-Runner/blob/master/build/windows/Readme_Install.txt

MacOS: https://github.com/josStorer/RWKV-Runner/blob/master/build/darwin/Readme_Install.txt

Linux: https://github.com/josStorer/RWKV-Runner/blob/master/build/linux/Readme_Install.txt

Server-Deploy-Examples: https://github.com/josStorer/RWKV-Runner/tree/master/deploy-examples

下载

- 28.3 MB 2023-07-09T04:45:17Z

- 5.23 MB 2023-07-09T04:45:55Z

- 10.6 MB 2023-07-09T04:45:17Z

v1.3.5

Changes

fix build for macos and linux

update Related Repositories

fix loss parser

improve wsl dependencies installation

improve finetune guide

refresh local models in real-time (#98)

improve python script error messages

support using directory as training data

关于RWKV-Runner模型训练的详细教程步骤等 博主会研究明白后发布

还有一个叫 ChatRWKV 地址https://github.com/BlinkDL/ChatRWKV

相关信息

中文使用教程:

https://zhuanlan.zhihu.com/p/618011122

https://zhuanlan.zhihu.com/p/616351661